一、简述

生成式人工智能是一种可用于创建内容(包括对话、故事、图像、视频和音乐)的人工智能。人工智能技术试图在图像识别、自然语言处理(NLP)和翻译等非传统计算任务中模仿人类智能。生成式人工智能是人工智能的发展方向。您可以训练其学习人类语言、编程语言、艺术、化学、生物学或任何复杂的主题。生成式人工智能可以重复使用训练数据来解决新问题。例如,学习英语词汇并根据其处理的字词创作一首诗。您的组织可以将生成式人工智能用于各种用途,例如聊天机器人、媒体创作以及产品开发和设计。

生成式人工智能算法可以用新的方式探索和分析复杂的数据。因此,研究人员可以发现原本可能不明显的新趋势和模式。这些算法可以汇总内容,概述多种解决方案路径,集思广益,并根据研究笔记创建详细的文档。这就是生成式人工智能可极大地增强研究和创新的原因所在。

例如,制药行业正在使用生成式人工智能系统来生成和优化蛋白质序列,并显著加快推进药物发现。

二、基本运作机制

像所有人工智能一样,生成式人工智能的运作方式是使用机器学习模型,机器学习模型是根据大量数据进行预训练的超大型模型。

基础模型(FM)是在广泛的广义和未标记数据上训练的机器学习模型。这些模型能够执行各种各样的一般任务。 FM 是这项已经发展了数十年的技术的最新进展结果。通常,FM 使用学习的模式和关系来预测序列中的下一个项目。 例如,在生成图像时,模型会分析图像并创建更清晰、更明确定义的图像版本。同样,对于文本,模型会根据之前的单词及其上下文预测文本字符串中的下一个单词。然后,模型使用概率分布技术选择下一个单词。

大型语言模型(LLM)就是一类基础模型。例如,OpenAI 的生成式预训练traneformer(GPT)模型是 LLM。LLM 专门处理基于语言的任务,例如摘要、文本生成、分类、开放式对话和信息提取。 LLM 的与众不同在于它们能够执行多项任务。实现此功能的原因是 LLM 包含许多参数,使其能够学习高级概念。 像 GPT这样的 LLM 可以考虑数十亿个参数,并且能够根据很少量的输入生成内容。通过在预训练中接触各种形式和多种模式的互联网规模数据,LLM 学会了在各种环境中应用它们的知识。

三、主流生成式人工智能模型

传统的机器学习模型具有辨别性,或者侧重于对数据点进行分类。它们尝试确定已知因素和未知因素之间的关系。例如,这些模型查看图像,即像素排列、线条、颜色和形状等已知数据,然后将它们映射到字词,即未知因素。从数学上讲,这些模型的工作原理是识别可以用数值方式将未知和已知因素映射为 x 和 y 变量的方程。

生成式模型在此基础上更进一步。这些模型不是在给定某些特征的情况下预测标签,而是在给定具体标签的情况下尝试预测特征。从数学上讲,生成式建模计算 x 和 y 同时出现的概率。该模型学习不同数据特征的分布及其关系。

例如,生成式模型分析动物图像以记录变量,例如不同的耳朵形状、眼睛形状、尾巴特征和皮肤图案。这些模型学习特征及其关系,以了解不同动物的总体外观。然后,它们可以重新创建训练集中没有的新动物图像。

接下来,我们给出几大类生成式人工智能模型。

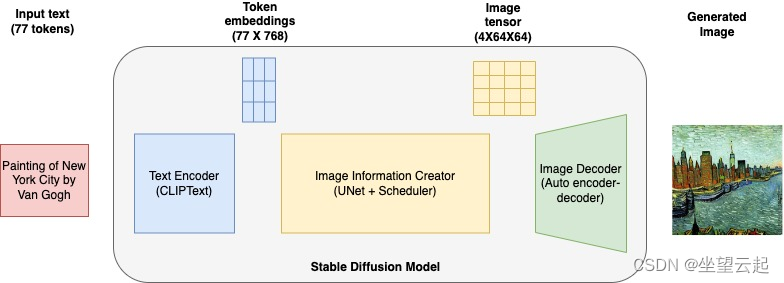

扩散模型

扩散模型通过对初始数据样本进行迭代性的受控随机更改来创建新数据。这些模型以原始数据为起点,然后加入细微的变化(噪点),逐渐使其与原始数据不那么相似。这种噪点经过仔细控制,以确保生成的数据保持一致性和真实性。

机器学习笔记 - Stable Diffusion 都使用了哪些技术?-CSDN博客文章浏览阅读2次。Stable Diffusion在2022年8月开源,是由慕尼黑大学的CompVis研究团队开发的生成式人工神经网络。该项目由初创公司StabilityAI、CompVis和Runway合作开发,并得到了EleutherAI和LAION的支持。截至2022年10月,StabilityAI已筹集了1.01亿美元的资金。Stable-Diffusion-WebUI是一个能够在浏览器上运行的网页版,它是一个具有跨时代意义的产品,让普通用户能够真正体验到AI绘画的无限魅力。https://skydance.blog.csdn.net/article/details/139539395 在多次迭代中添加噪点之后,扩散模型反转该过程。反向去噪会逐渐消除噪点,从而产生与原始数据样本相似的新数据样本。

生成对抗网络

生成对抗网络(GAN)是另一种基于扩散模型概念的生成式人工智能模型。 GAN 的工作原理是以竞争方式训练两个神经网络。第一个网络称为生成者,通过添加随机噪点来生成虚假的数据样本。第二个网络称为辨别者,其尝试区分真实数据和生成者产生的虚假数据。

机器学习笔记 - 生成对抗网络 (GAN)概述和入门示例_gan网络实例-CSDN博客文章浏览阅读3.2k次,点赞2次,收藏16次。生成对抗网络 (GAN) 是一类功能强大的神经网络,用于无监督学习。它是由 Ian J. Goodfellow 在 2014 年开发和引入的。GAN 基本上由两个相互竞争的神经网络模型组成的系统,它们相互竞争,能够分析、捕获和复制数据集中的变化。在 GAN 中,有一个生成器和一个鉴别器。生成器生成假数据样本(无论是图像、音频等)并试图欺骗鉴别器。另一方面,鉴别器试图区分真假样本。生成器和判别器都是神经网络,它们在训练阶段都相互竞争。重复这些步骤,在这个过程中,生成器和鉴别器在每次重复......_gan网络实例https://skydance.blog.csdn.net/article/details/123602075 在训练过程中,生成者不断提高其创建逼真数据的能力,而辨别者日益加强区分真假数据的能力。这种对抗过程一直持续到生成者产生的数据令人信服,以至于辨别者无法将其与真实数据区分。 GAN 广泛用于生成逼真的图像、风格转换和数据增强任务。

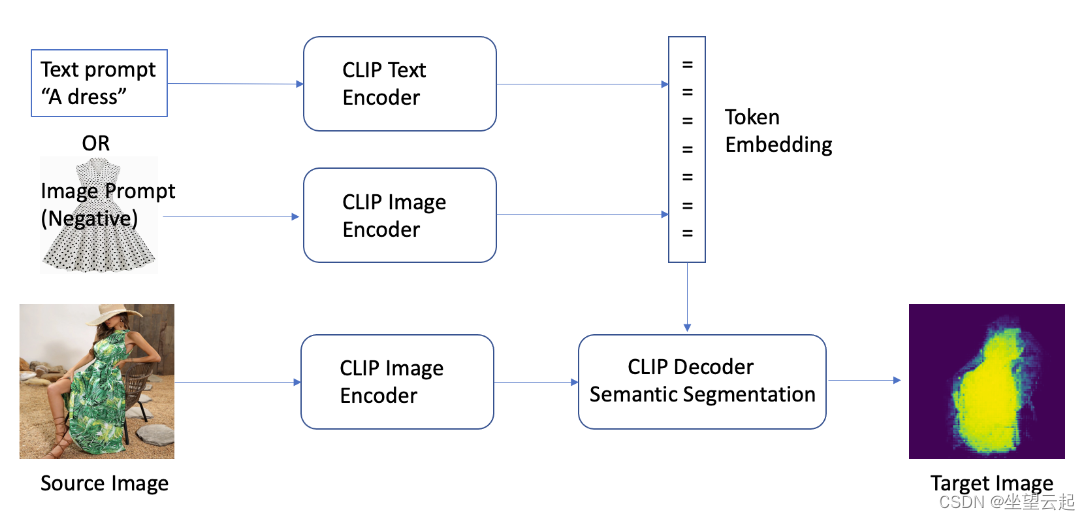

变分自动编码器

变分自动编码器(VAE)学习一种称为潜在空间的紧凑数据表示形式。潜在空间是数据的数学表示形式。可以将潜在空间视为唯一的代码,根据数据的所有属性来表示数据。例如,如果研究面部,则潜在空间包含代表眼睛形状、鼻子形状、颧骨和耳朵的数字。

机器学习笔记 - 自动编码器autoencoder_自动编码器自动是什么意思-CSDN博客文章浏览阅读9.4k次,点赞10次,收藏88次。自编码器是开发无监督学习模型的主要方式之一。但什么是自动编码器?简而言之,自动编码器通过接收数据、压缩和编码数据,然后从编码表示中重构数据来进行操作。对模型进行训练,直到损失最小化并且尽可能接近地再现数据。通过这个过程,自动编码器可以学习数据的重要特征。自动编码器是由多个层组成的神经网络。自动编码器的定义方面是输入层包含与输出层一样多的信息。输入层和输出层具有完全相同数量的单元的原因是自动编码器旨在复制输入数据。然后分析数据并以无监督方式重建数据后输出数据副本。_自动编码器自动是什么意思https://skydance.blog.csdn.net/article/details/123567960 VAE 使用两个神经网络 — 编码器和解码器。编码器神经网络将输入数据映射为潜在空间每个维度的均值和方差。该神经网络从高斯(正态)分布中生成随机样本。此样本是潜在空间中的一个点,表示输入数据的压缩简化版本。

解码器神经网络从潜在空间中获取此取样点,然后将其重新构造回与原始输入相似的数据。使用数学函数衡量重新构造的数据与原始数据的匹配程度。

基于traneformer的模型

基于traneformer的生成式人工智能模型建立在 VAE 的编码器和解码器概念之上。基于traneformer的模型为编码器添加更多层,以提高理解、翻译和创意写作等文本式任务的处理性能。

基于traneformer的模型使用自注意力机制。在处理序列中的每个元素时,这些模型权衡输入序列中不同部分的重要性。 另一个关键功能是这些人工智能模型实现上下文嵌入。序列元素的编码不仅取决于元素本身,还取决于其在序列中的上下文。

要理解基于traneformer的模型如何运作,可以将语句想象成单词序列。 自注意力可以帮助模型在处理每个单词时将注意力集中在相关的单词上。为获取单词之间不同类型的关系,基于traneformer的生成式模型采用称为注意力头的多个编码器层。每个头都学习关注输入序列的不同部分。这样,模型就可以同时考虑数据的各个方面。 每个层还会对上下文嵌入进行优化。这些层使嵌入的信息更丰富,同时可获取从语法句法到复杂语义的所有内容。

四、技术演变

神经网络和深度学习是现代生成式人工智能的最新先驱技术。2013 年开发而成的变分自动编码器是第一个可以生成逼真图像和语音的深度生成模型。

VAE 引入创建多种数据类型创新变体的功能。该功能推动其他生成式人工智能模型的迅速出现,例如生成式对抗网络和扩散模型。这些创新侧重于让生成的数据日益类似于真实数据,尽管这些数据是人为创建的。

2017 年,随着traneformer的推出,人工智能研究发生进一步的转变。traneformer将编码器和解码器架构与注意力机制无缝集成。traneformer以卓越的效率和多功能性简化语言模型的训练过程。像 GPT 这样的著名模型已成为基础模型,它们能够在广泛的原始文本语料库上进行预训练,并针对不同的任务进行微调。 traneformer变革自然语言处理可能实现的功能。它们为从翻译、摘要到回答问题等任务提供了生成式功能。 许多生成式人工智能模型持续取得长足进步,并且已经形成跨行业应用。最近的创新侧重于完善模型以使用专有数据。研究人员还希望创建越来越类似人类行为的文本、图像、视频和语音。