文章目录

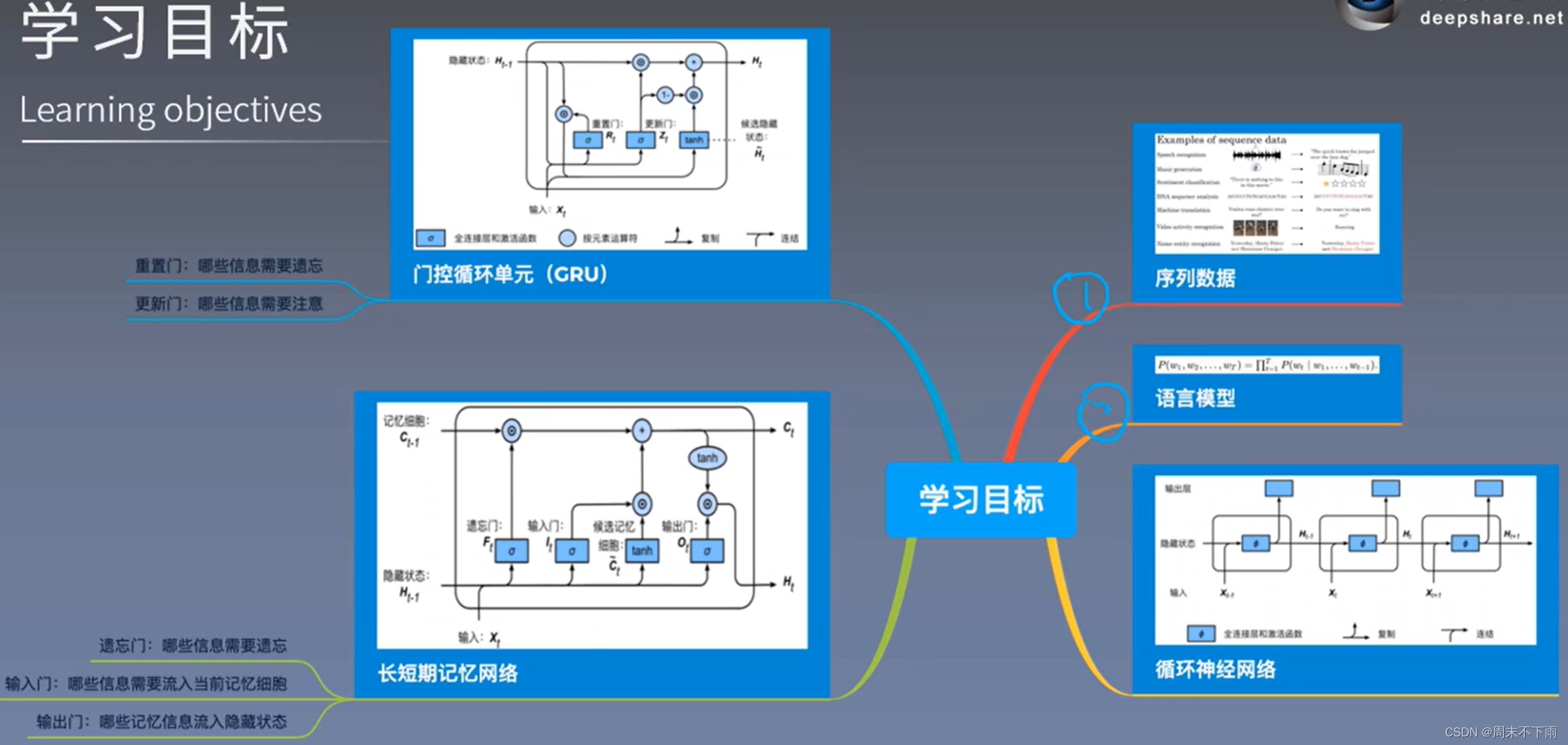

- 一、 学习目标

- 二、序列数据

- 三、语言模型

- 四、循环神经网络

- 4.1 RNN的反向传播

- 五、门控循环单元-GNU

- 5.1 候选隐藏状态

- 六、长短期记忆网络-LSTM

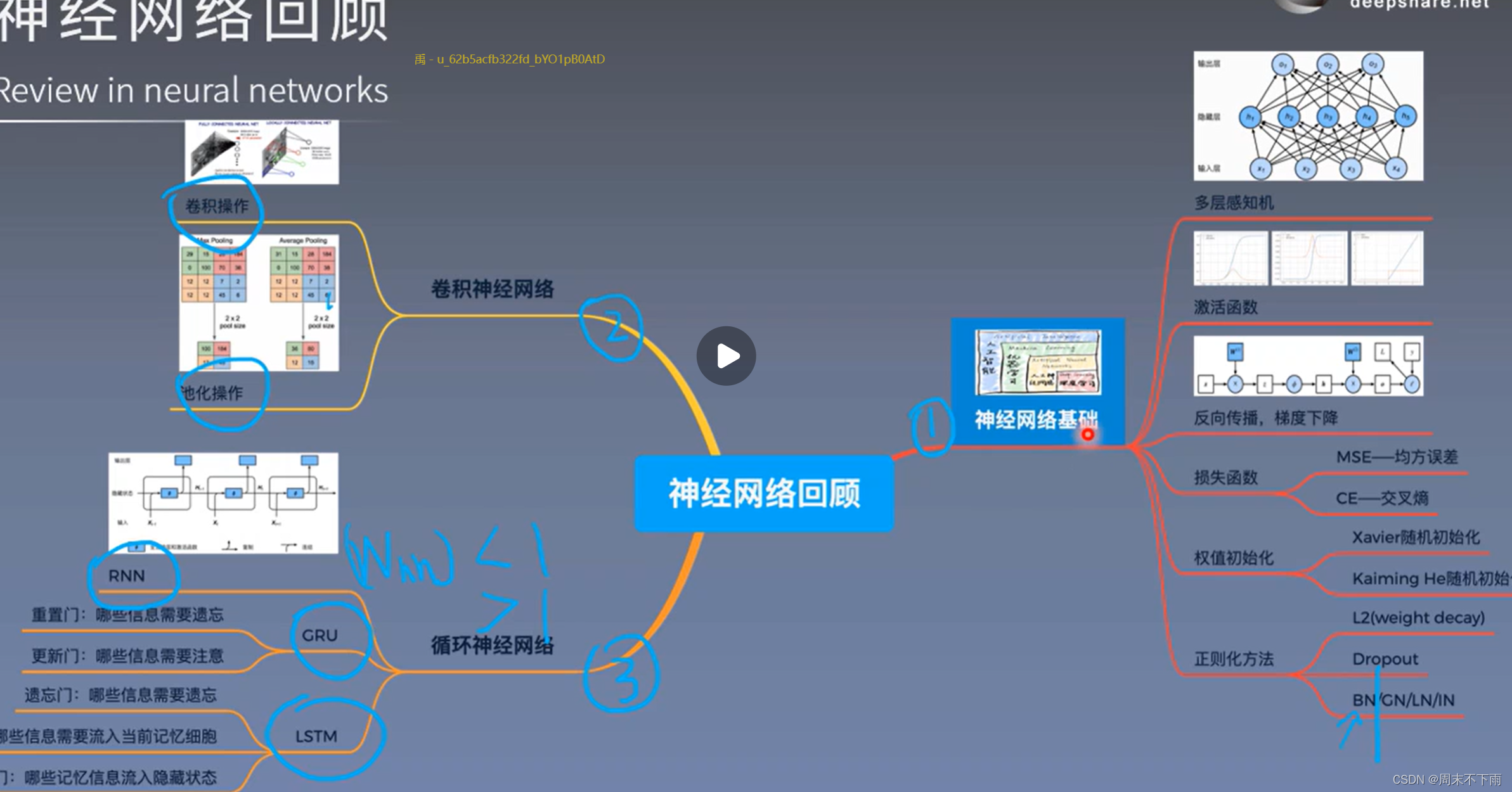

- 七、回顾

一、 学习目标

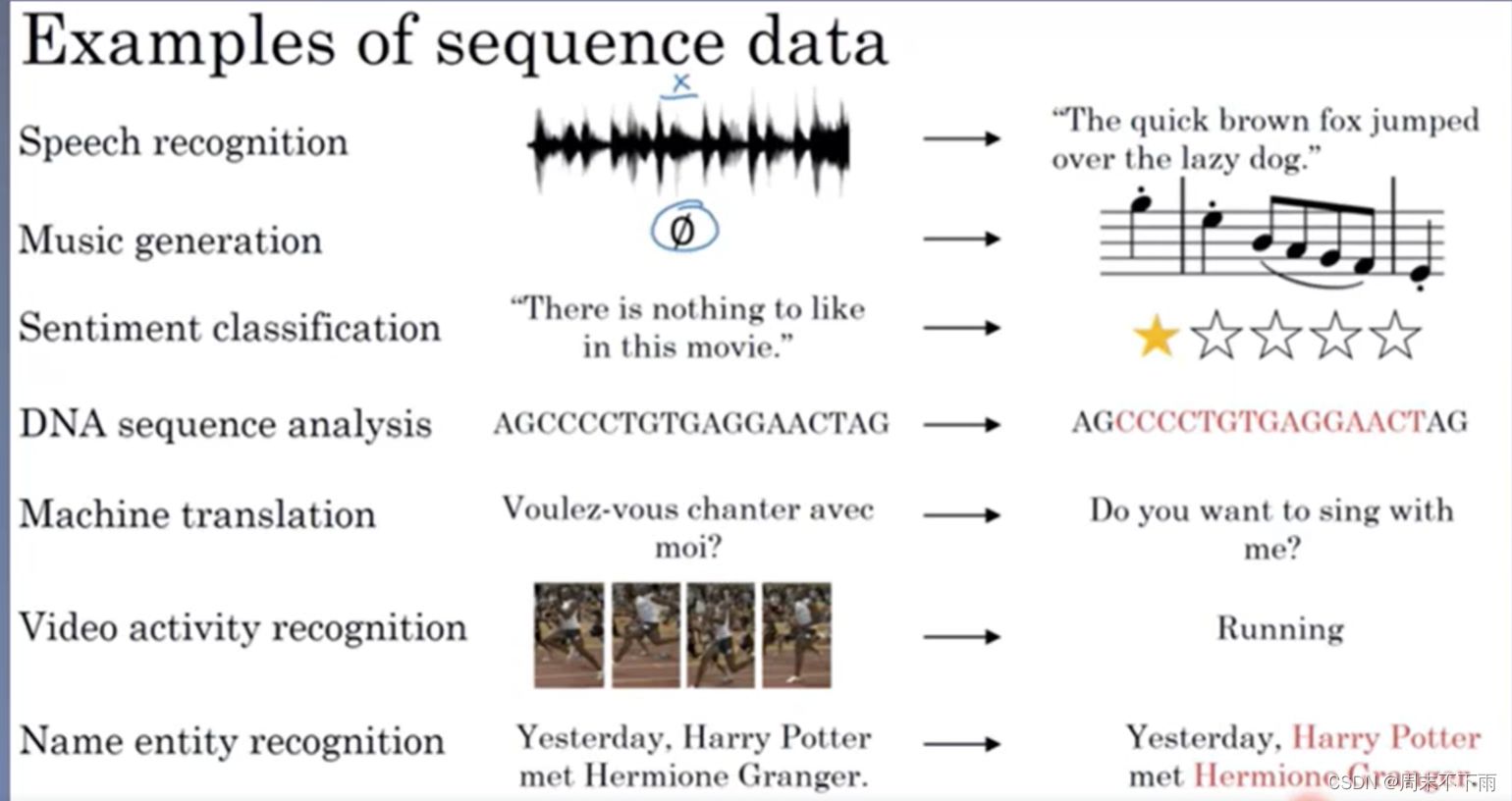

二、序列数据

序列数据是常见的数据类型,前后数据通常具有关联性

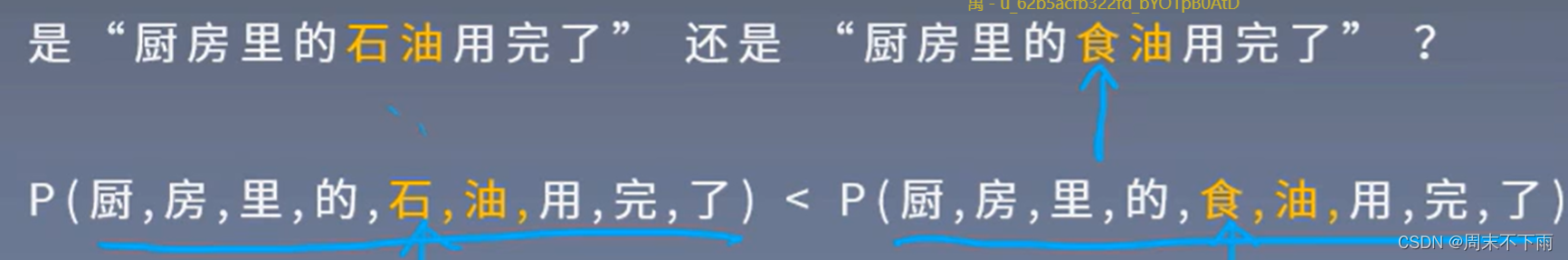

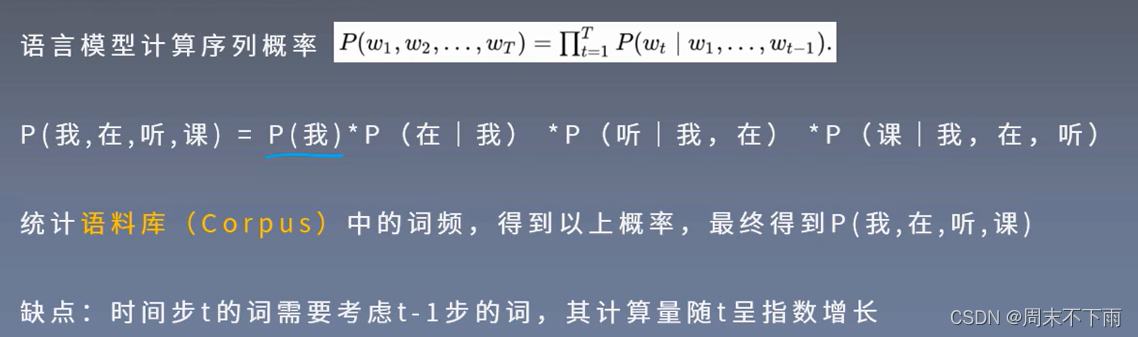

三、语言模型

综合考虑序列数据的关联性

如果句子里面的字数一多,那么计算量就会非常大。

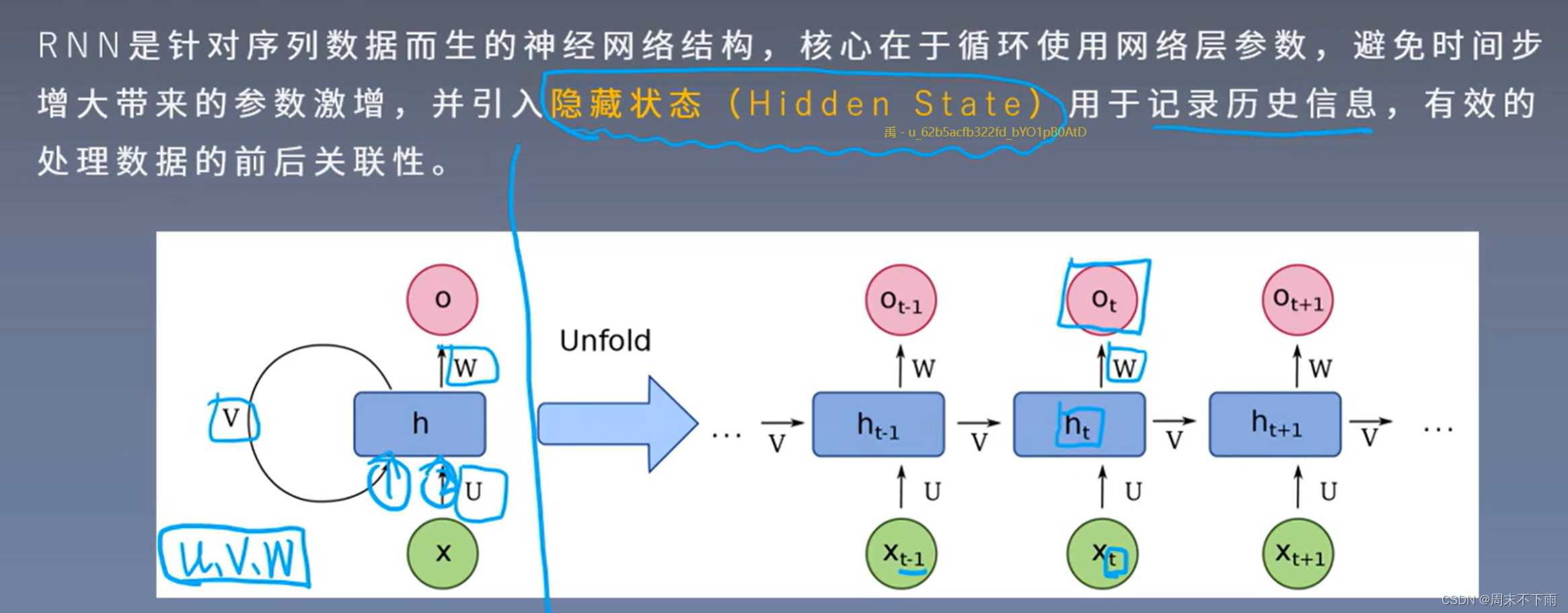

四、循环神经网络

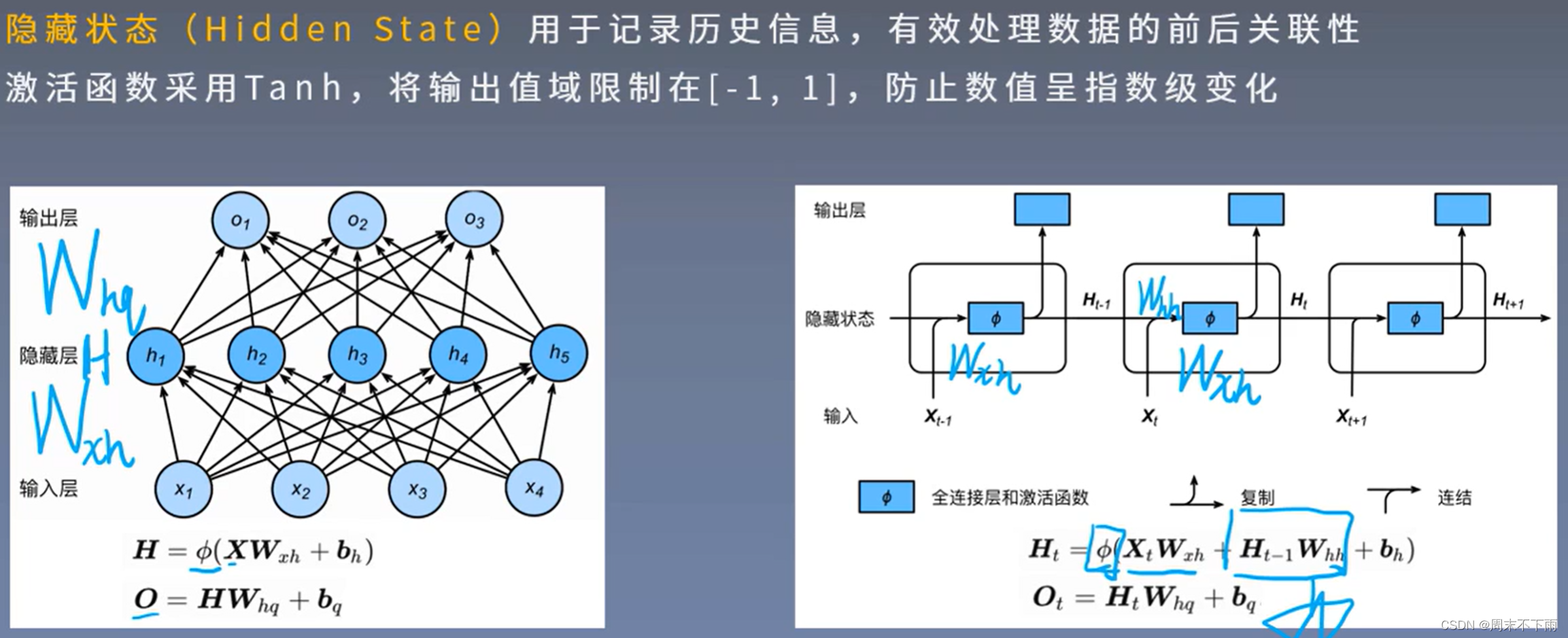

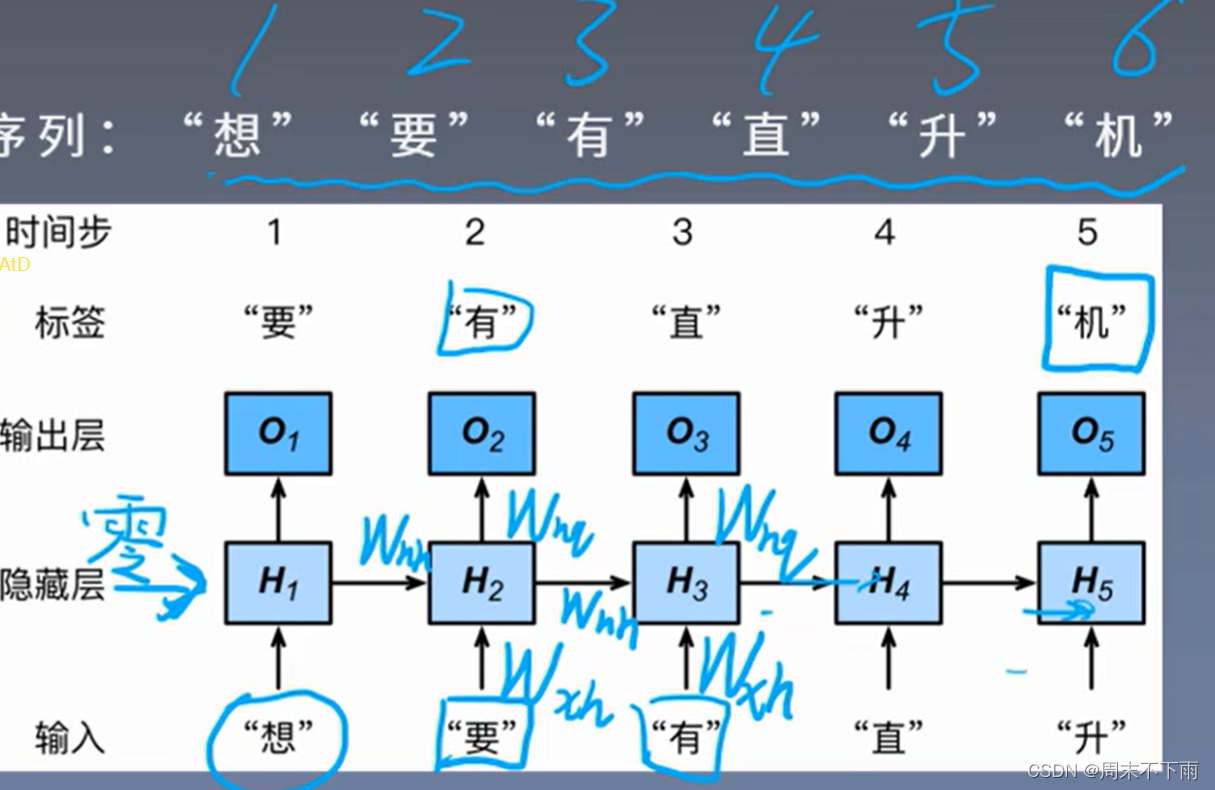

上一个的时间步的隐藏布,会对下一个的时间步的隐藏布产生影响。

多层感知机和循环神经网络

循环神经网络会记录历史信息。W权重矩阵是循环使用的,(Wxh、Whh、Whq)这三个是不会变化的

- 循环神经网络的隐藏状态可以捕捉截至当前时间步的序列的历史信息

- 循环神经网络模型参数的数量不随时间步的增加而增长

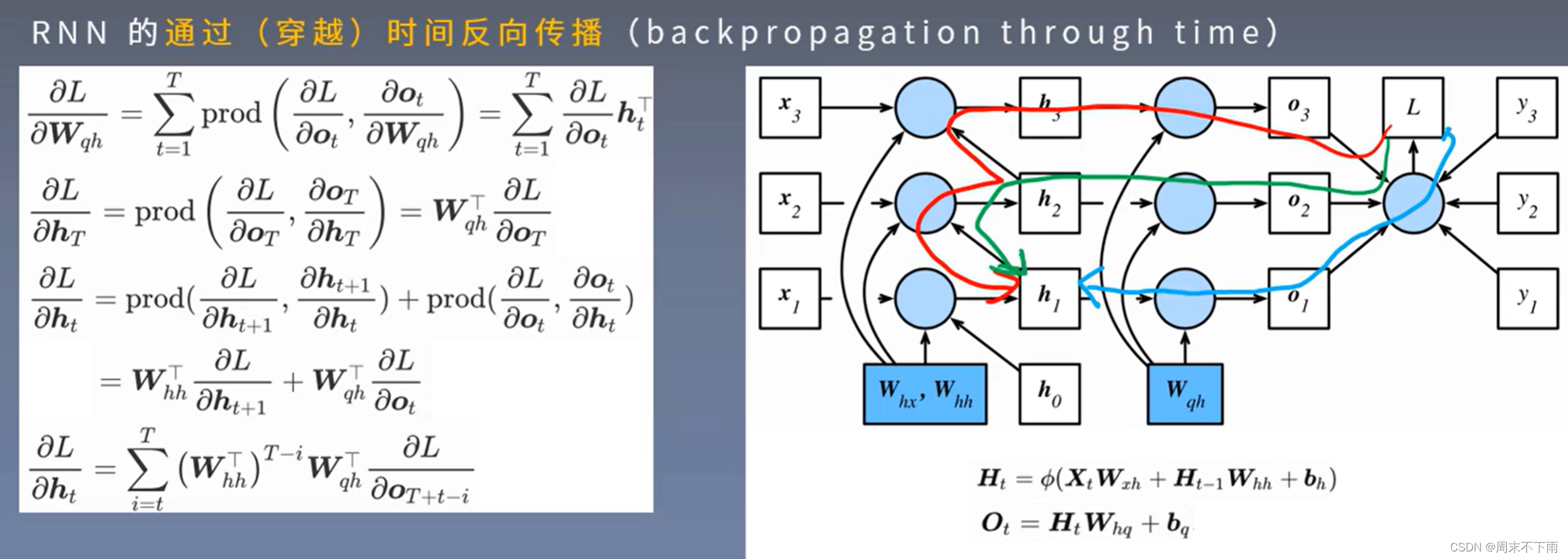

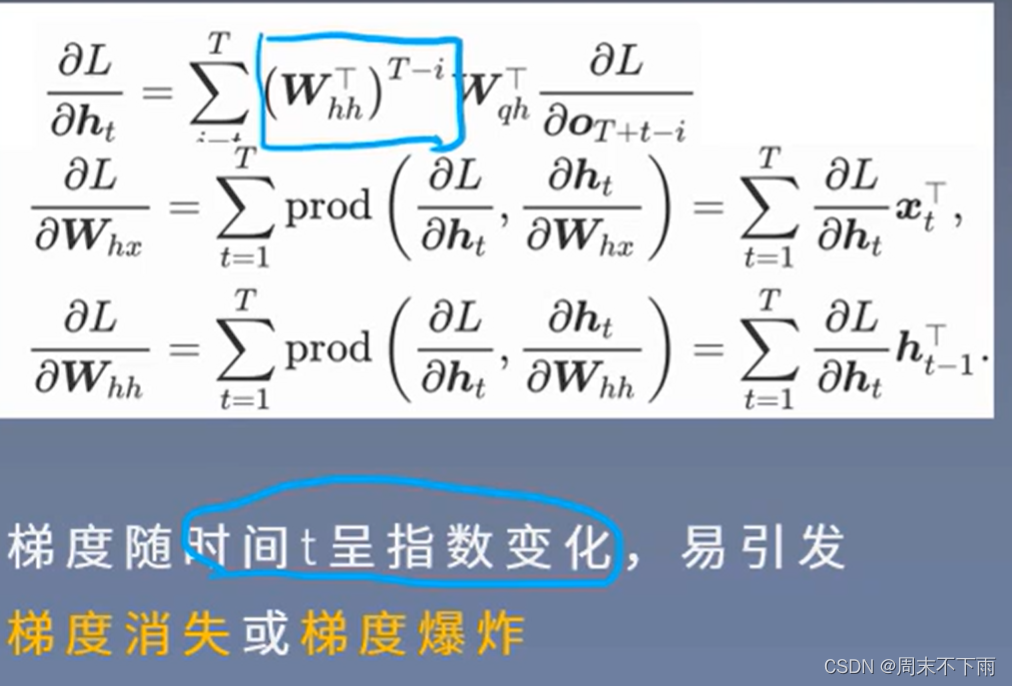

4.1 RNN的反向传播

也称穿越时间的反向传播

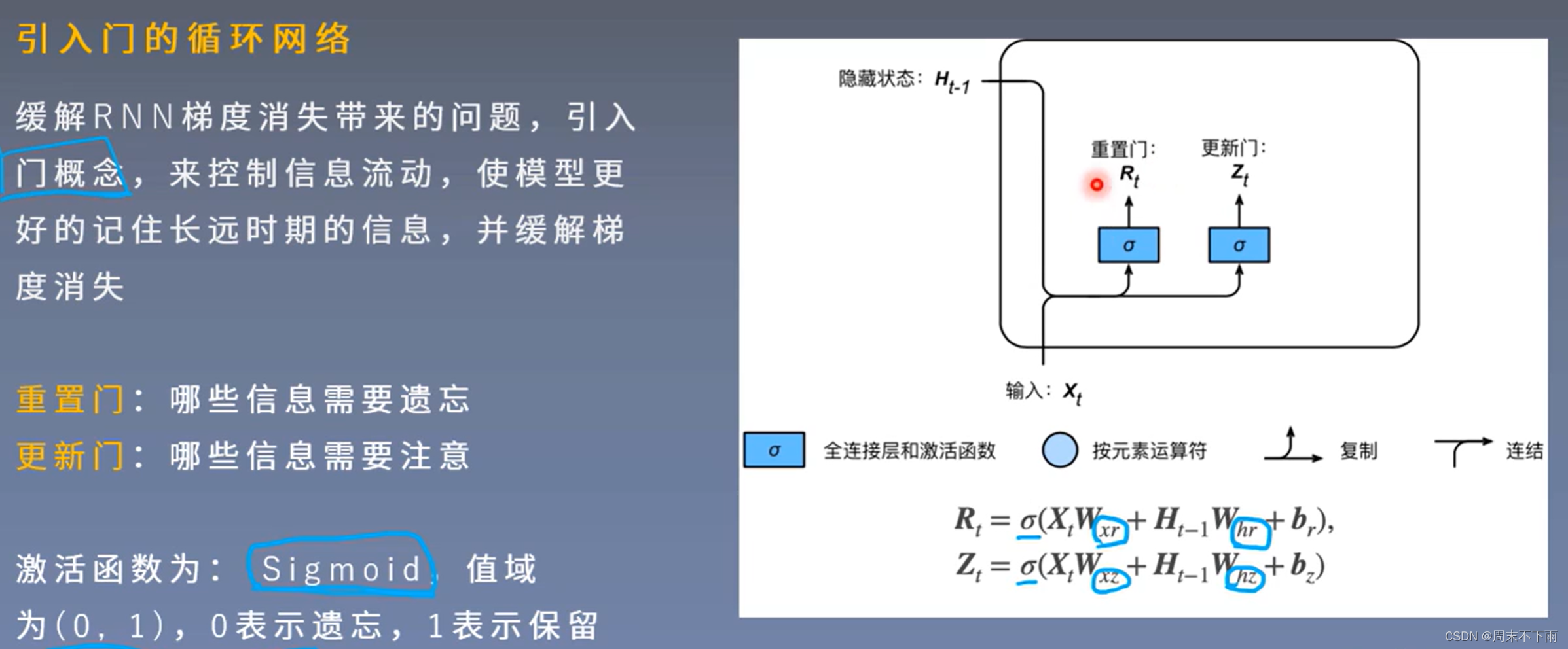

五、门控循环单元-GNU

引入门的原因:防止梯度消失

有重置门、更新门。使用激活函数Sigmoid进行判决

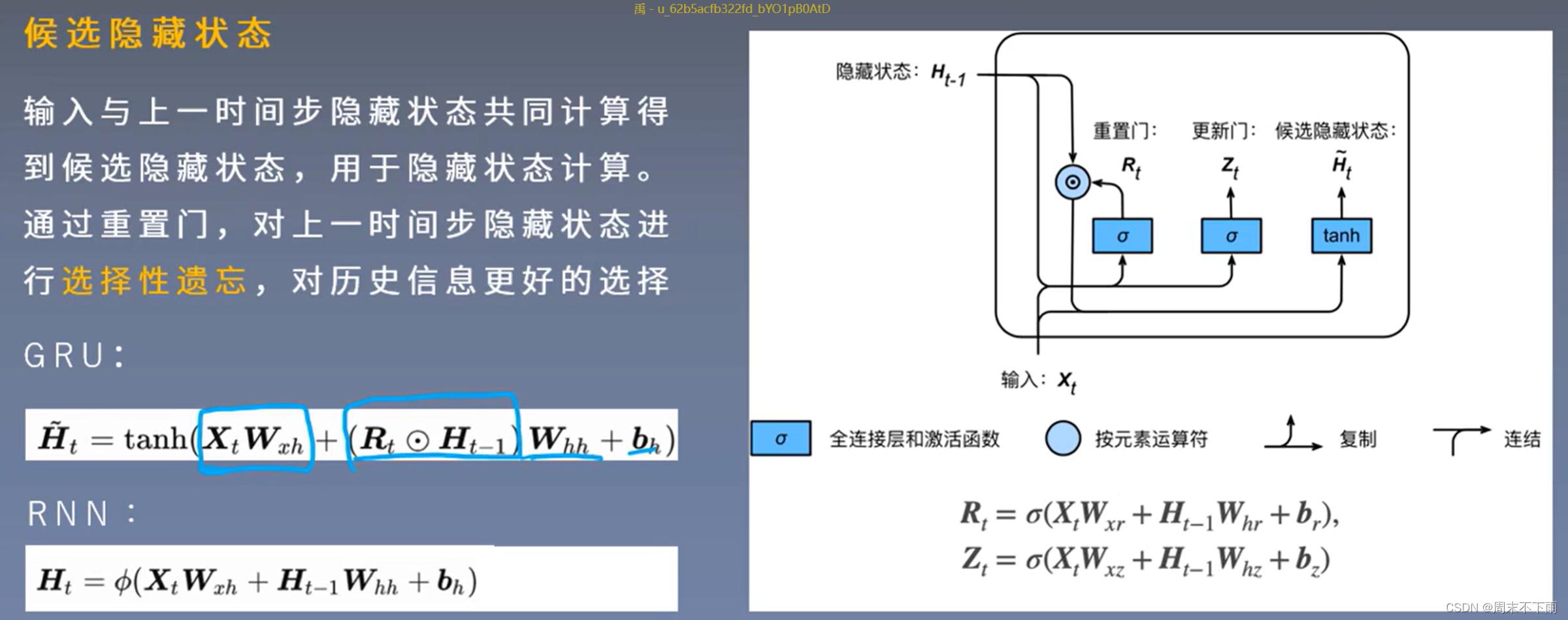

5.1 候选隐藏状态

与RNN相比,可以判断是否需要上一个时间布的隐藏状态,从而得出候选隐藏状态。

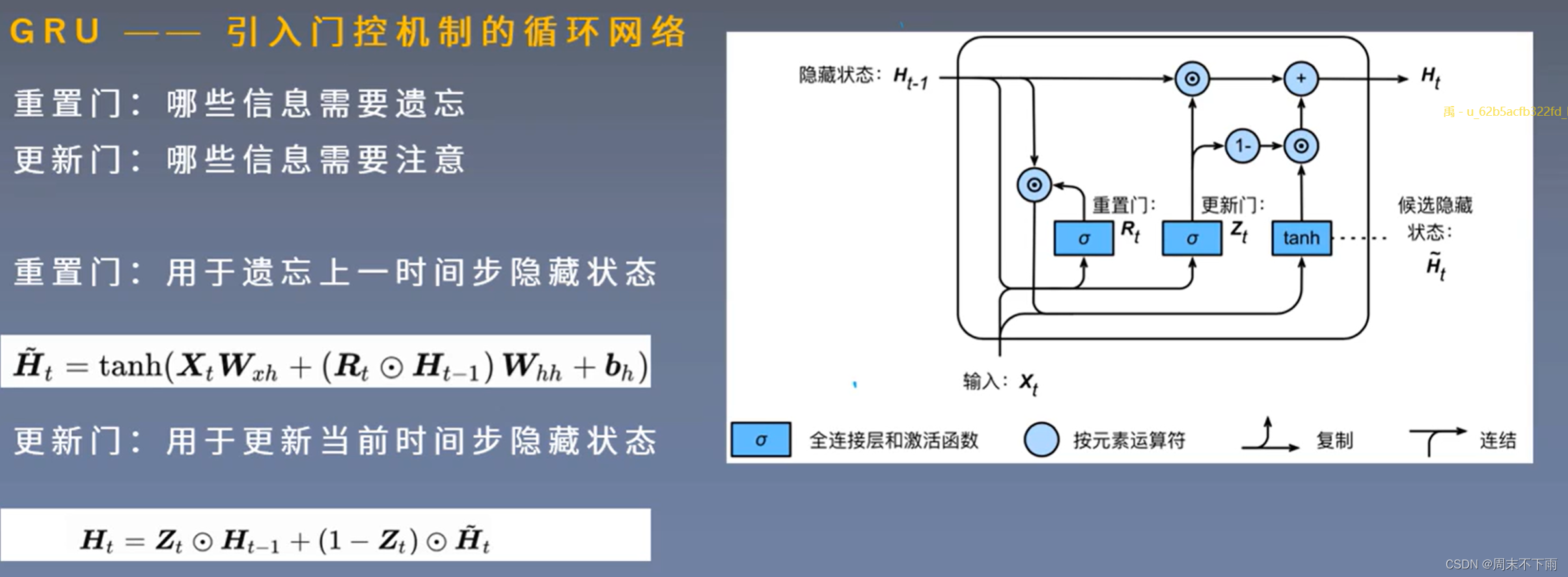

之后候选隐藏状态与更新门相连接,最后得出下一个隐藏状态

重置门用于候选隐藏状态计算过程当中用来控制上一时间步控制隐藏状态要遗忘哪些信息。

更新门更新当前时间步隐藏状态的时候去组合上一时间步隐藏状态H_t-1以及当前时间步的候选隐藏状态H^~这样进行组合,得到H_t

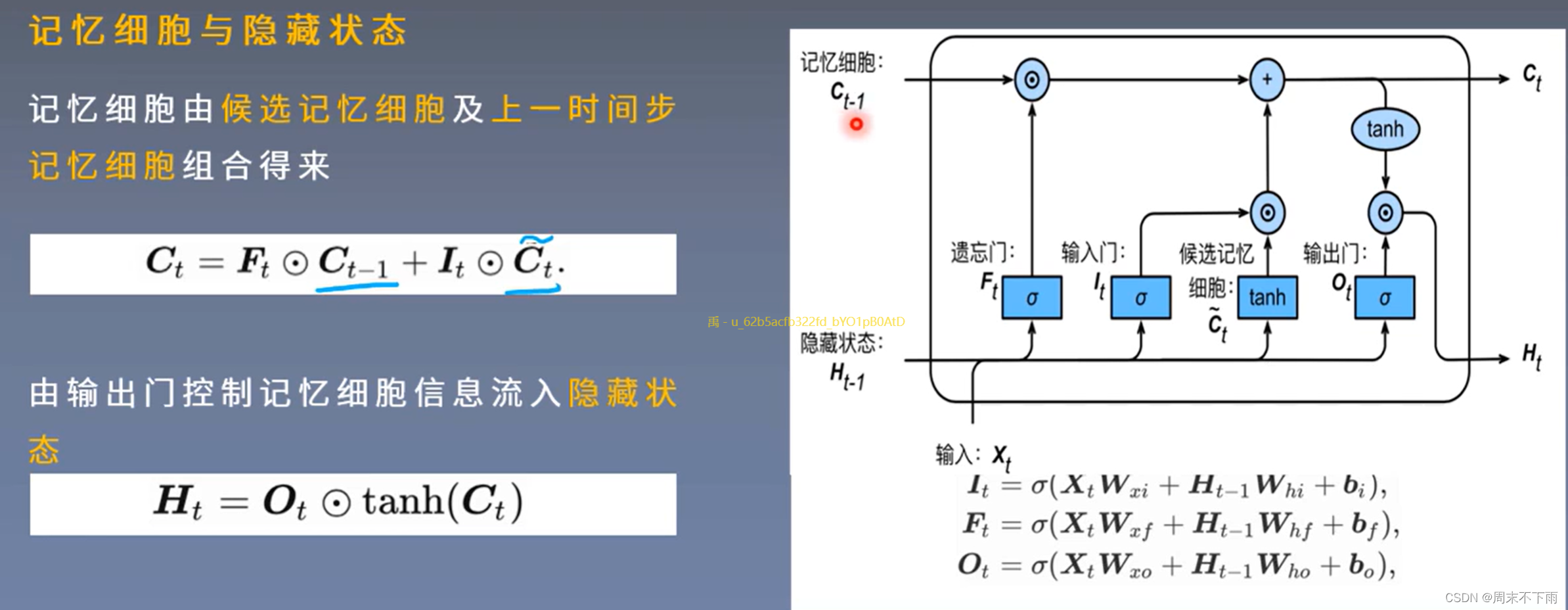

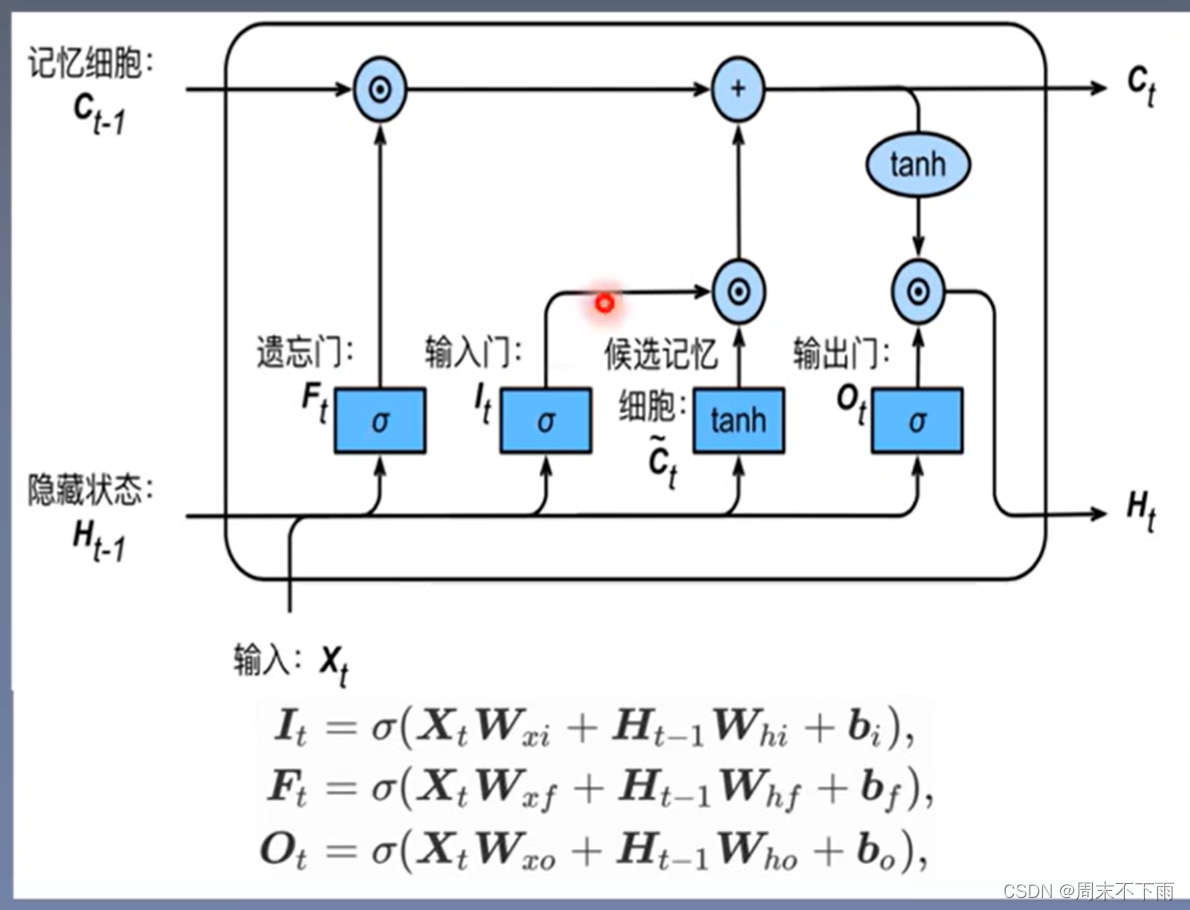

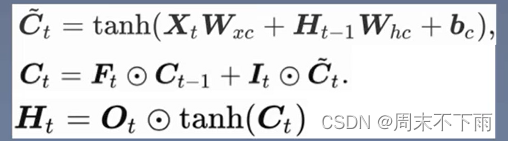

六、长短期记忆网络-LSTM

个人理解就是长期记忆就是依赖于记忆细胞

主要记住上面这个示意图就能理解LSTM了。

七、回顾

其中BN后面几个都是BN的推广。BN会在baseline里面讲到