🌍 珠峰登顶“堵车”后冰架断裂 5人坠崖 2人没爬上来!

珠峰登顶“堵车”后冰架断裂 5人坠崖 2人没爬上来!

🎄 Windows 11 Beta 22635.3646 预览版发布:中国大陆地区新增“微软电脑管家”应用

✨ 成都限购解除即将满月:有新盘“基本每天都签单成交” 外地购房者明显增多

1.马斯克AI领域动作频频:规划“算力超级工厂”

根据最新报道,xAI不仅正在与马斯克的“老对手”扎克伯格争夺与定制化聊天机器人团队Character.ai合作的机会,同时公司在算力建设方面的消息也颇为吸引眼球。

与扎克伯格“冤家路窄”

随着马斯克收购推特(现在改名为X)后,他与Meta老板扎克伯格就成了直接竞争对手。而社交媒体平台对定制化聊天AI的独特需求,也使得他们同时叩响了硅谷创业公司Character.ai的大门。

Character.ai是一家专门开发AI聊天机器人创作平台的公司,致力于打造模拟真实人物(例如黄仁勋、爱因斯坦)或虚拟人物(例如游戏《原神》的里某个角色)语言风格的聊天机器人。

(由用户创建并发布在平台上的“爱因斯坦机器人”,来源:Character.ai)

值得强调的是,Character.ai的创始人Noam Shazeer,正是当年谷歌Transformer论文的作者之一。时隔多年,这批开创当今AI新格局的谷歌研究员们纷纷踏上了创业的道路。

(Transformer论文作者齐聚今年英伟达GTC大会,左二为Noam Shazeer,来源:英伟达)

据多名知情人士表示,Meta公司与xAI都与Character.ai展开了早期的讨论,主要涉及研究层面的合作,例如模型开发和预训练。

Meta此前曾表示,正在整合AI人物聊天机器人到旗下Facebook、Instagram等多个平台,其中也会包括一些“扮演名人”的机器人。与此同时,xAI也开发了聊天机器人Grok,供X平台的付费订阅用户使用。

对于马斯克和扎克伯格而言,他们在开发专属人物AI层面也有一项其他科技巨头不具备的优势——手里有着大量社交媒体的数据。

建设“算力超级工厂”

在AI领域要有一番作为,也离不开持续砸钱搞算力。

根据科创媒体The Information周六报道,在今年5月的一次投资者演示中,马斯克表示xAI计划建造一台规格惊人的超级计算机,直言这将是一个“算力超级工厂”。

今年早些时候,马斯克曾经透露,训练Grok 2模型大约需要2万个英伟达H100 GPU,而训练下一代模型以及更高版本则会需要10万个英伟达H100芯片。

颇为符合马斯克豪迈风格的是,他准备把所有芯片全串进一台“超级计算机”里。他对投资者们表示,这个项目如果能够完成,将至少是当今存在的最大GPU集群规模的四倍。马斯克同时也表态会亲自下场,推动这台机器在2025年秋季运作起来,并补充称可能会与甲骨文合作开发这台庞大的计算机。

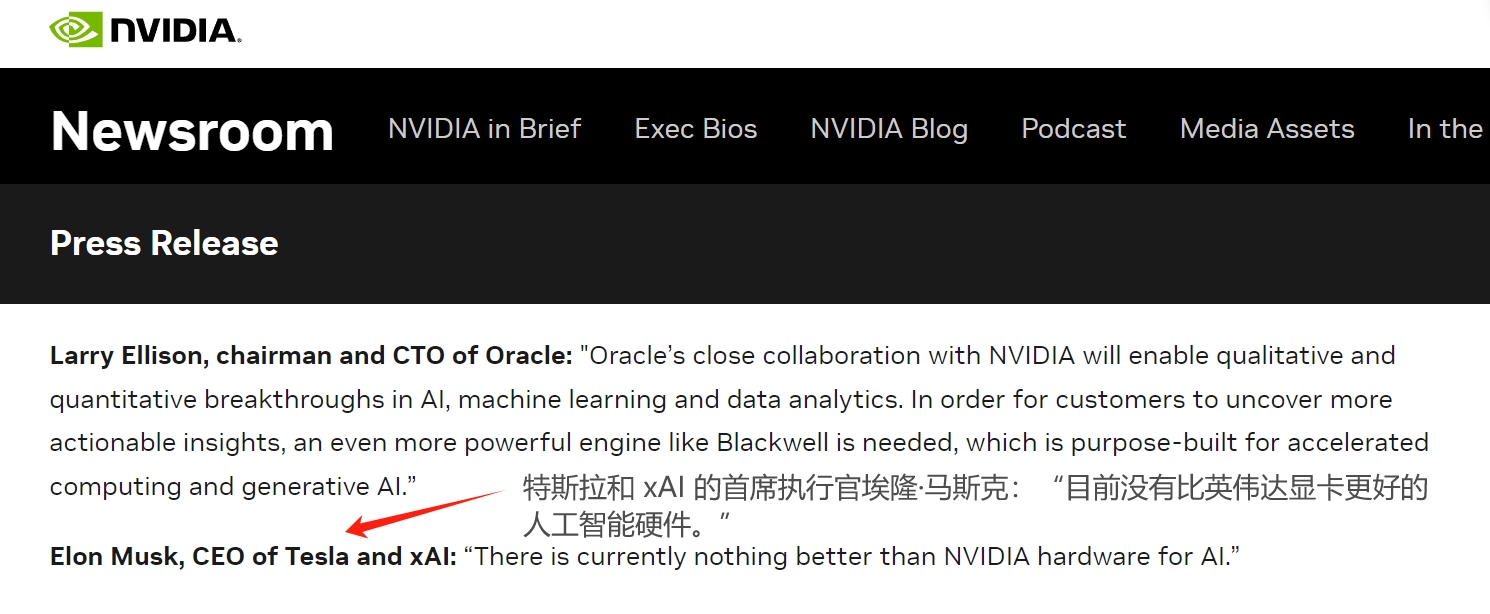

虽然特斯拉自己也在开发Dojo超算,但“算力超级工厂”依然还是要排队抢购英伟达的芯片。在今年3月英伟达的Blackwell新闻稿中,马斯克就公开喊话称英伟达的人工智能硬件是“最好的”。

(来源:英伟达)

值得一提的是,本月中旬时曾有消息称,xAI接近与甲骨文达成一项持续多年、价值“百亿美元”的云算力供应协议,一度推高甲骨文股价。一边不断采购算力,同时自建“算力超级工厂”,xAI追赶市场领跑者的架势已经显露无疑。

有知情人士称,xAI正在以240亿美元的估值目标展开融资,计划在未来几周内筹集超过60亿美元。粗略估算,这笔钱大概够买20万个H100芯片。

从AI大厂的角度来看,60亿美元大概只够烧1-2年的功夫。马斯克自己也曾承认,现阶段要在AI赛道具有竞争力,每年至少要花几十亿美元。

题外话:AI大佬早早布局“泛AI赛道”

随着英伟达本周又一次交出验证AI景气度的财报,美股市场也呈现了新的动向——除了炒芯片股外,资金也开始运作电力、电厂、电气设备、光伏等与数据中心配套有关的板块。

马斯克自然不必多说,特斯拉旗下拥有成熟的储能业务,同时也是不少光伏发电厂、光伏设备制造商的供应商。

OpenAI首席执行官山姆·奥尔特曼投资的核裂变初创公司Oklo也在本月中旬登陆美股市场。公司的首席执行官Jacob DeWitte本周接受采访时表示,目前来询问电力采购的80%客户都是数据中心运营商,他预期这种状况只是“冰山一角”,未来数据中心的需求还会更多。

Oklo本周宣布签订了一份100兆瓦规模的数据中心园区供电协议。不过公司至今尚未获得建设小型核电站的许可,DeWitte也表示2027年前都不太可能有投入运营的电站。

2.Mojo崛起:AI-first 的编程语言能否成为新流行

1.AI语言的上一个黄金时代

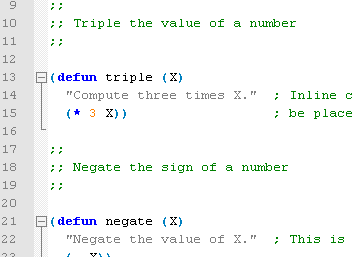

这并不是AI第一次推动新编程语言的浪潮。20世纪70年代和80年代是AI语言的黄金时代,如LISP和Prolog,它们引入了开创性的概念,如符号处理和逻辑编程。那时,AI也是热门话题。

值得注意的是,LISP语言对软件的未来产生了深远影响,推出了函数式编程范式,最终影响了现代语言如Python、Haskell和Scala的设计。LISP也是首批实现动态类型的语言之一,在这种类型中,类型与值相关联而不是变量,允许更多的灵活性和更容易的原型开发。它还引入了垃圾回收功能,自动回收不再使用的内存,这是许多现代编程语言(如Java、Python和JavaScript)所采用的功能。可以公平地说,没有LISP,我们今天可能不会在这里。

当AI领域在20世纪70年代和80年代经历了一段资金和兴趣减少的长时间时,被称为“AI寒冬”,对专门AI语言如LISP的关注开始减退。同时,通用计算的快速发展导致了通用语言如C的兴起,这些语言为各种应用(包括系统编程和数值计算)提供了更好的性能和可移植性。

图片

2.AI-first语言的回归

现在,历史似乎在重演,AI再次推动了新编程语言的发明,以解决其棘手的问题。现代AI算法所需的强大数值计算和并行处理突显了需要能够有效桥接抽象和充分利用底层硬件的语言。

可以说,这一趋势始于TensorFlow的Tensor计算语法、Julia以及重新燃起的对数组导向语言如APL和J的兴趣,这些语言提供了与机器学习和神经网络的数学基础相一致的领域特定构造。这些项目试图减少将数学概念转换为通用代码的开销,让研究人员和开发人员能够更多地关注核心AI逻辑,而不是低级实现细节。

最近,一波新的AI-first语言应运而生,它们从头开始设计,以解决AI开发的特定需求。Higher Order Company创建的Bend旨在为AI提供灵活和直观的编程模型,具有自动微分和与流行AI框架的无缝集成功能。Modular AI开发的Mojo则专注于高性能、可扩展性和构建与部署AI应用的易用性。Swift for TensorFlow是Swift编程语言的扩展,结合了Swift的高级语法和TensorFlow的机器学习能力。这些语言代表了朝向AI开发的专用工具和抽象的日益增长的趋势。

虽然Python、C++和Java等通用语言在AI开发中仍然很受欢迎,但AI-first语言的复兴表明,AI的独特需求需要专门为该领域量身定制的语言,就像早期的AI研究催生了LISP等语言一样。

3.Python在AI中的局限性

Python因其简单性、通用性和广泛的生态系统长期以来一直是现代AI开发者的首选。然而,它的性能限制对于许多AI用例来说是一个主要缺点。

用Python训练深度学习模型可能会非常慢——我们说的是像在DMV(车辆管理局)排队等候那样慢,等待收银员找零那样慢。像TensorFlow和PyTorch这样的库通过使用底层的C++来帮助提高性能,但Python仍然是瓶颈,特别是在预处理数据和管理复杂的训练工作流时。

在实时AI应用如自动驾驶或实时视频分析中,推理延迟至关重要。然而,Python的全局解释器锁(GIL)阻止了多个本机线程同时执行Python字节码,导致在多线程环境中表现不佳。

在大规模AI应用中,内存管理效率对于最大化可用资源的利用至关重要。Python的动态类型和自动内存管理会增加内存使用和碎片化。像C++和Rust这样的语言提供的低级内存控制允许更有效地使用硬件资源,从而提高AI系统的整体性能。

在生产环境中部署AI模型,特别是在具有有限计算资源的边缘设备上,用Python可能会遇到挑战。Python的解释性和运行时依赖性会导致资源消耗增加和执行速度变慢。像Go或Rust这样的编译语言,因其较低的运行时开销和更好的系统资源控制,通常更适合在边缘设备上部署AI模型。

4.Mojo:新的AI-first编程语言,无缝衔接Python生态

Mojo是一种新编程语言,承诺弥合Python的易用性和前沿AI应用所需的超快性能之间的差距。Mojo由Swift编程语言和LLVM编译器基础架构的创建者Chris Lattner创立的公司Modular开发。Mojo是Python的超集,这意味着开发者可以利用他们现有的Python知识和代码库,同时解锁前所未有的性能提升。Mojo的创造者声称,它可以比Python代码快多达35000倍。

Mojo设计的核心是其与AI硬件(如运行CUDA的GPU和其他加速器)的无缝集成。Mojo使开发者能够充分利用专用AI硬件的潜力,而不必陷入低级细节中。

Mojo的一个主要优势是它与现有Python生态系统的互操作性。与Rust、Zig或Nim等语言不同,Mojo允许开发者编写与Python库和框架无缝集成的代码。开发者可以继续使用他们喜欢的Python工具和包,同时受益于Mojo的性能增强。

Mojo引入了几项使其与Python区别开来的功能。它支持静态类型,可以帮助在开发早期捕捉错误并实现更有效的编译。然而,开发者仍然可以在需要时选择动态类型,提供灵活性和易用性。语言引入了新的关键字,如“var”和“let”,提供不同程度的可变性。Mojo还包括一个新的“fn”关键字,用于在严格的类型系统内定义函数。

Mojo还采用了类似于Rust的所有权系统和借用检查器,确保内存安全并防止常见编程错误。此外,Mojo提供指针的内存管理,使开发者可以对内存分配和释放进行细粒度控制。这些功能有助于Mojo的性能优化,并帮助开发者编写更高效和无错误的代码。

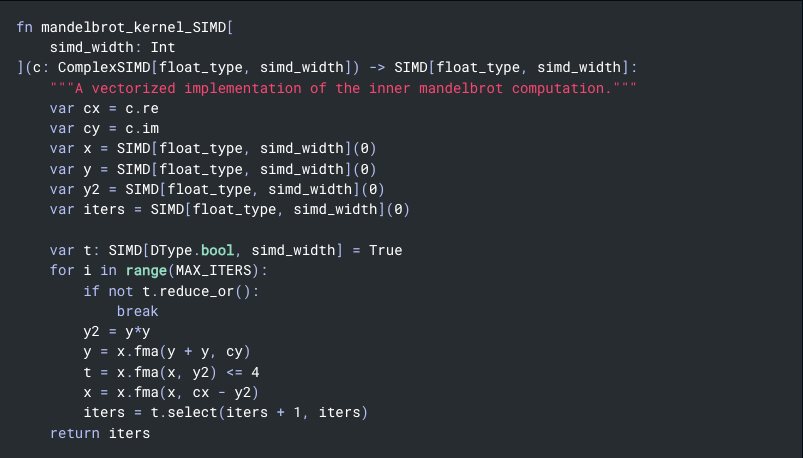

Mojo最令人兴奋的方面之一是其加速AI开发的潜力。Mojo能够编译成高度优化的机器代码,可以在CPU和GPU上本地速度运行,使开发者能够在不牺牲性能的情况下编写复杂的AI应用。语言包括数据并行性、任务并行性和流水线处理的高级抽象,使开发者能够用最少的代码表达复杂的并行算法。

Mojo在概念上比一些其他新兴AI语言(如Bend)更低级,后者将现代高级语言功能编译到Apple Silicon或NVIDIA GPU上的本地多线程。Mojo提供对并行性的细粒度控制,特别适合手工编码现代神经网络加速。通过为开发者提供直接控制计算映射到硬件上的能力,Mojo实现了高度优化的AI实现。

图片

5.利用开源的力量

根据Mojo的创建者Modular的说法,自去年8月普遍可用以来,该语言已经吸引了超过17.5万开发者和5万家组织。

尽管Mojo的性能和潜力令人印象深刻,但其最初的采用可能因其专有状态而停滞不前。

然而,Modular最近决定将Mojo的核心组件在定制版Apache 2许可下开源。此举可能会加速Mojo的采用,并培育更充满活力的协作和创新生态系统,类似于开源是Python等语言成功的关键因素。

开发者现在可以探索Mojo的内部工作原理,为其开发做出贡献,并从其实现中学习。这种协作方式可能会导致更快的错误修复、性能改进和新功能的增加,最终使Mojo更加多功能和强大。

宽松的Apache许可证允许开发者自由使用、修改和分发Mojo,鼓励围绕该语言的生态系统的增长。通过开源,Mojo有潜力吸引更多的开发者、研究人员和企业,使其成为AI开发的重要工具。

开放源码的决定还表明Modular对其技术和开发社区的信心。通过拥抱开源模式,Modular表明他们致力于透明度、协作和技术进步,这可能会吸引更广泛的开发者社区并加速Mojo的采用。

6.全新的AI优先编程浪潮

虽然Mojo是一个有前途的新进入者,但它并不是唯一一个试图成为AI开发首选的语言。还有几种其他新兴语言也是从头开始设计的,以满足AI工作负载的需求。

一个显著的例子是Swift for TensorFlow,这是一个雄心勃勃的项目,旨在将Swift的强大语言功能带入机器学习。由谷歌和苹果公司合作开发,Swift for TensorFlow允许开发者使用原生Swift语法表达复杂的机器学习模型,并且具备静态类型、自动微分和XLA编译以在加速器上进行高性能执行。不幸的是,谷歌已经停止了该项目的开发,项目现在已归档,这显示了即使是谷歌这样的巨头在新语言开发中获得用户吸引力的难度。

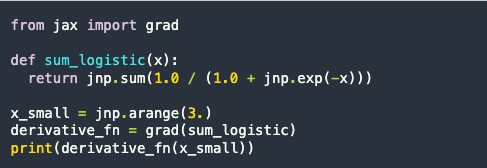

此后,谷歌越来越关注JAX,一个用于高性能数值计算和机器学习(ML)的库。JAX是一个Python库,提供高性能的数值计算和机器学习功能,支持自动微分、XLA编译和高效使用加速器。虽然它不是独立的语言,但JAX扩展了Python,使其具有更具声明性和功能性的风格,非常符合机器学习的数学基础。

图片

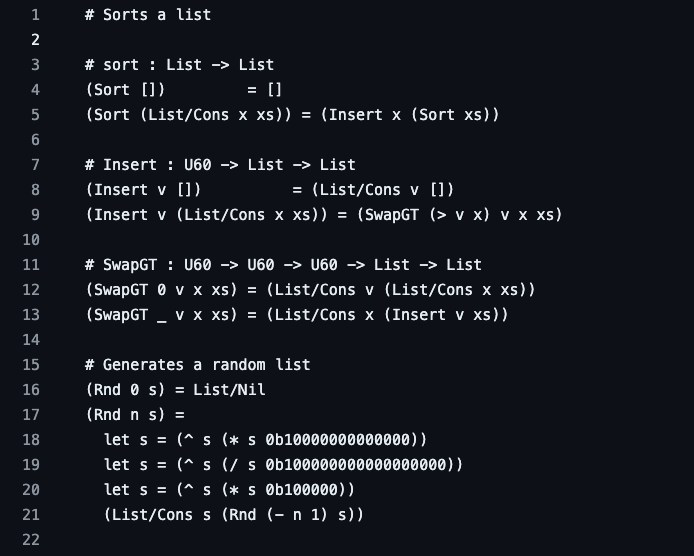

最新的新增内容是Bend,一种大规模并行的高级编程语言,可以将类似Python的语言直接编译成GPU内核。与CUDA和Metal等低级语言不同,Bend更像是Python和Haskell,提供快速对象分配、全闭包支持的高阶函数、不受限制的递归,甚至继续执行。它运行在大规模并行硬件(如GPU)上,基于核心数量实现近线性加速,无需显式的并行注释——没有线程生成、锁、互斥锁或原子操作。由HVM2运行时驱动,Bend在任何可能的地方利用并行性,使其成为AI的万能工具——适用于各种场合。

图片

这些语言利用现代语言特性和强类型系统,使AI算法的编码更加表达性和安全,同时仍然在并行硬件上提供高性能执行。

7.AI开发新时代的黎明

像Mojo、Bend、Swift for TensorFlow、JAX等以AI为重点的编程语言的复兴标志着AI开发新时代的开始。随着对更高效、更具表达性和硬件优化工具的需求增加,我们预计将看到更多专门针对AI独特需求的语言和框架的涌现。这些语言将利用现代编程范式、强类型系统以及与专用硬件的深度集成,使开发者能够构建具有前所未有性能的更复杂的AI应用。

AI优先语言的兴起可能会激发AI、语言设计和硬件开发之间相互作用的新一波创新。随着语言设计师与AI研究人员和硬件供应商密切合作以优化性能和表达性,我们可能会看到为这些语言和AI工作负载设计的新型架构和加速器的出现。

这种AI、语言和硬件之间的密切关系对于释放人工智能的全部潜力至关重要,能够在自动化系统、自然语言处理、计算机视觉等领域实现突破。我们今天创造的语言和工具正在重塑AI开发和计算的未来。

3.俄罗斯首台光刻机制造完成:可生产 350 纳米工艺芯片

Shpak 表示,“我们组装并制造了第一台国产光刻机。作为泽廖诺格勒技术生产线的一部分,目前正在对其进行测试。”俄罗斯接下来的目标是在 2026 年制造可以支持 130nm 工艺的光刻机。

据悉,350 纳米工艺的芯片现在仍然可以应用于汽车、能源和电信等多个行业。

据IT之家此前报道,俄罗斯科学院下诺夫哥罗德应用物理研究所 (IPF RAS) 曾于 2022 年宣布,正在开发俄罗斯首套半导体光刻设备,并对外夸下海口:这套光刻机能够使用 7nm 生产芯片,可于 2028 年全面投产。

据介绍,他们计划在六年内制作出光刻机的工业原型,首先要在 2024 年开发一台 alpha 机器。这一阶段的重点不在于其工作或解决的高速性,而在于所有系统的全面性。