- 【可控图像生成系列论文(一)】 简要介绍了论文的整体流程和方法;

- 【可控图像生成系列论文(二)】则将就整体方法、模型结构、训练数据和纹理迁移进行了更详细的介绍。

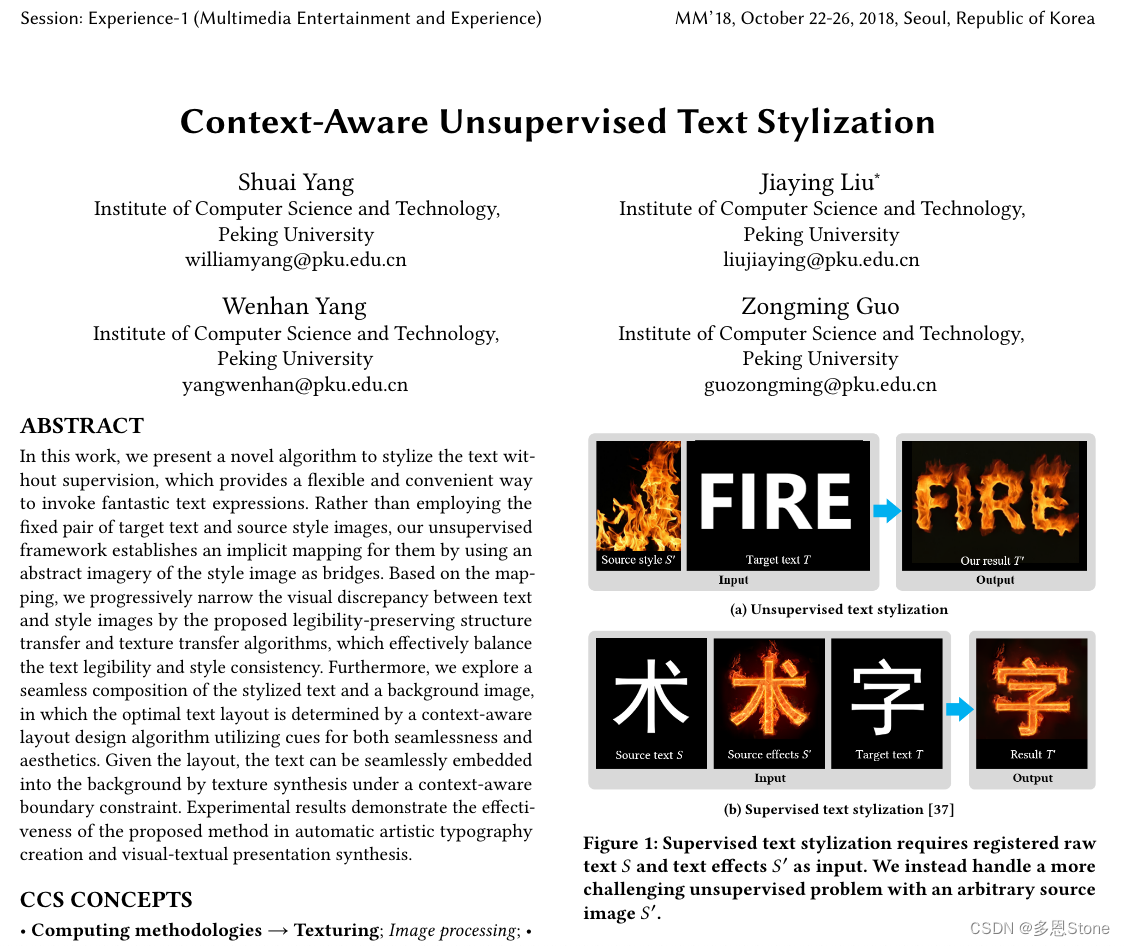

本篇将介绍来自 ACM MM 2018 的一篇字体风格化的可控生成工作《Context-Aware Unsupervised Text Stylization》,主要功能是无监督的文字风格化,输入为(a)中风格图的火焰+原始字体,得到风格化后的艺术字。

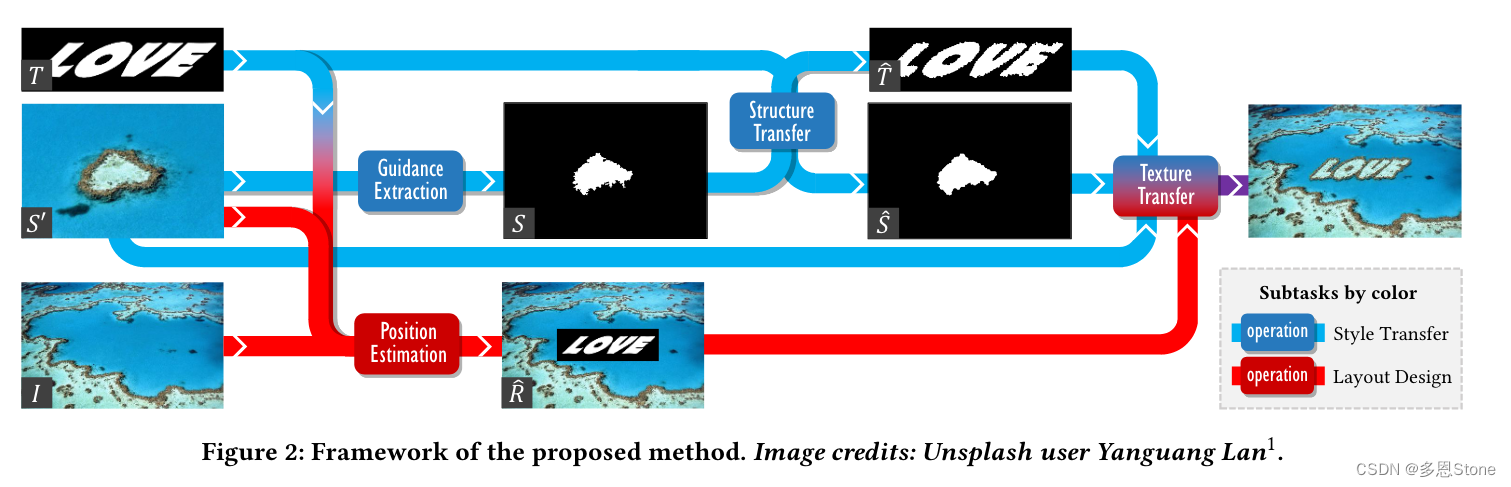

整体流程

- 作者提出了一种无监督的文本风格化算法。其中包括风格迁移(上图中蓝色)和布局设计(红色)两个方法。

- 风格迁移:作者提出了保持可读性的结构迁移(Structure Transfer)和纹理迁移(Texture Transfer)算法,逐步缩小文本和风格图像之间的视觉差异,从而有效地平衡了文本的可读性和风格一致性,并证明了这些算法在二值文本和风格图像之间的风格转换中是有效的。

- 布局设计:作者提出了一种上下文感知布局设计方法,以确定图像布局并将艺术文本无缝合成到背景图像中,从而创建出具有专业外观的视觉文本呈现。其中最佳文本布局由利用无缝性和美学提示的上下文感知布局设计算法确定。给定布局后,可以通过在上下文感知边界约束下的纹理合成将文本无缝嵌入背景中。

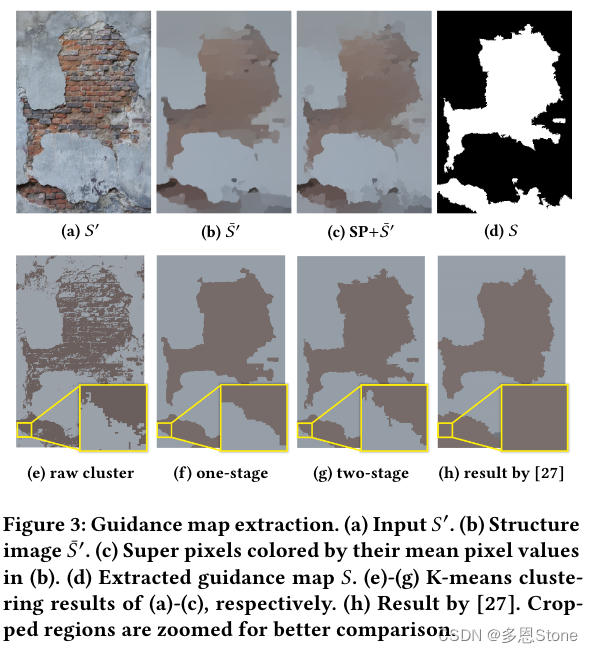

1-Guidance Extraction 引导图提取

- 对纹理的感知是获取抽象意象的过程,这使我们能够从无序的事物中看到具体的图像(例如云)。这启发作者通过模拟人类对纹理信息的抽象过程,从源图像 S′ 中提取出二值意象 S。

- S 作为引导图,其中白色像素表示文本内部(前景)的参考区域,黑色像素表示文本外部(背景)。前景和背景的边界描绘了 S′ 中纹理的形态特征。

- 作者提出了一种简单但有效的两阶段方法,将纹理抽象为前景和背景,并很好地保留了源纹理的形态特征。

- 具体来说,作者使用相对总变差(Relative Total Variation,RTV)1 去除纹理内部的颜色差异,获得结构图像 S ‾ ′ ~{\overline S^′} S′。然而, S ‾ ′ ~{\overline S^′} S′ 中纹理轮廓的细节也被平滑处理了(见图3(b)(f))。因此,作者提出了一种两阶段抽象方法:

- 在第一阶段,将 S ′ S^′ S′ 中的像素抽象为细粒度的超级像素2,以精确匹配纹理轮廓。每个超级像素使用其在 S ‾ ′ ~{\overline S^′} S′ 中的平均像素值作为其特征向量,以避免纹理差异。

- 在第二阶段,通过 K-means 聚类(K = 2)将超级像素进一步抽象为粗粒度的前景和背景。图3展示了该两阶段方法生成的石膏墙精确抽象意象的示例。

- 在这个示例中,结果在边界上比单阶段方法具有更多的细节,并且比最先进的标签图提取方法 3 错误更少(见图3(h)中放大的区域)。最后,检测 S ′ S^′ S′ 中的像素显著性 4,并将平均像素显著性较高的聚类设置为前景。

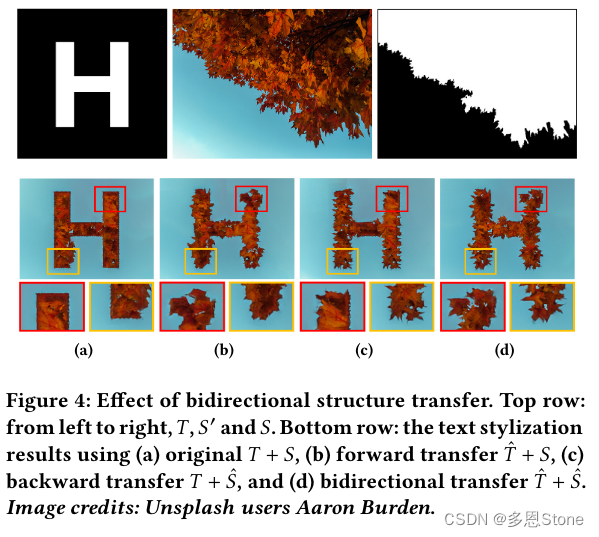

2-Structure Transfer 结构迁移

- 直接使用通过 Guidance Extraction 提取的 S S S 与 T T T 进行风格转移会导致不自然的纹理边界,如图4(a)所示。对此的解决方案是采用形状合成技术 5,以最小化 S S S 和 T T T 之间的结构不一致性。

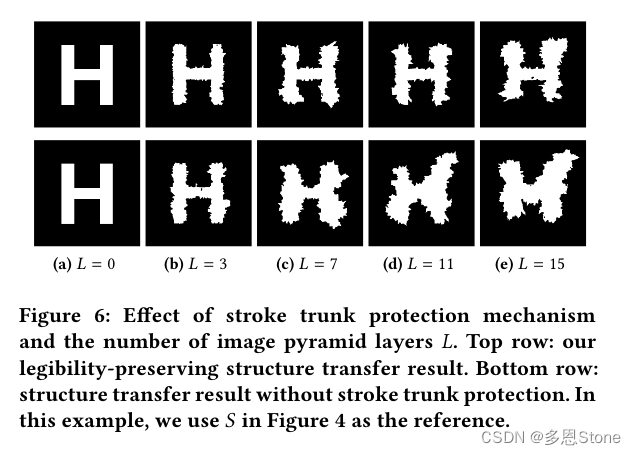

- 在分层形状合成(Layered Shape Synthesis,LSS)6 中,形状被表示为多个分辨率下的边界片段集合,并通过优化双向相似性函数将一种形状的风格转移到另一种形状上。然而,在我们的任务中,这种方法没有考虑可读性,文本在调整后会变得不可读。

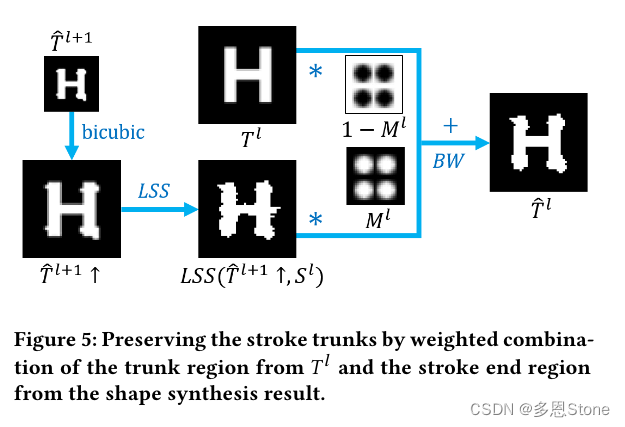

如图6底行所示,“H”被变形成“X”和“M”。因此,作者将笔画主干保护机制结合到 LSS 中,提出了一种保持可读性的结构转移方法。主要思想是调整笔画末端的形状,同时保留笔画主干的形状,因为字形的可读性主要由其主干形状决定。

Li Xu, Qiong Yan, Yang Xia, and Jiaya Jia. 2012. Structure extraction from texture via relative total variation. ACM Transactions on Graphics 31, 6 (2012), 139. ↩︎

Radhakrishna Achanta, Appu Shaji, Kevin Smith, Aurelien Lucchi, Pascal Fua, and Sabine Süsstrunk. 2012. SLIC superpixels compared to state-of-the-art superpixel methods. IEEE Transactions on Pattern Analysis and Machine Intelligence 34, 11 (2012), 2274–2282. ↩︎

Yitzchak David Lockerman, Basile Sauvage, Rémi Allègre, Jean-Michel Dischler, Julie Dorsey, and Holly Rushmeier. 2016. Multi-scale label-map extraction for texture synthesis. ACM Transactions on Graphics 35, 4 (2016), 140. ↩︎

Jianming Zhang and Stan Sclaroff. 2013. Saliency detection: A boolean map approach. In Proc. Int’l Conf. Computer Vision. 153–160. ↩︎

Amir Rosenberger, Daniel Cohen-Or, and Dani Lischinski. 2009. Layered shape synthesis: automatic generation of control maps for non-stationary textures. ACM Transactions on Graphics 28, 5 (2009), 107. ↩︎

Amir Rosenberger, Daniel Cohen-Or, and Dani Lischinski. 2009. Layered shape synthesis: automatic generation of control maps for non-stationary textures. ACM Transactions on Graphics 28, 5 (2009), 107. ↩︎