往期热门专栏回顾

| 专栏 | 描述 |

|---|---|

| Java项目实战 | 介绍Java组件安装、使用;手写框架等 |

| Aws服务器实战 | Aws Linux服务器上操作nginx、git、JDK、Vue |

| Java微服务实战 | Java 微服务实战,Spring Cloud Netflix套件、Spring Cloud Alibaba套件、Seata、gateway、shadingjdbc等实战操作 |

| 毕设 | 大数据、Java Sprinboot、微服务等 |

| Java基础篇 | Java基础闲聊,已出HashMap、String、StringBuffer等源码分析,JVM分析,持续更新中 |

| Springboot篇 | 从创建Springboot项目,到加载数据库、静态资源、输出RestFul接口、跨越问题解决到统一返回、全局异常处理、Swagger文档 |

| Spring MVC篇 | 从创建Spring MVC项目,到加载数据库、静态资源、输出RestFul接口、跨越问题解决到统一返回 |

| 华为云服务器实战 | 华为云Linux服务器上操作nginx、git、JDK、Vue等,以及使用宝塔运维操作添加Html网页、部署Springboot项目/Vue项目等 |

| Java爬虫 | 通过Java+Selenium+GoogleWebDriver 模拟真人网页操作爬取花瓣网图片、bing搜索图片等 |

| Vue实战 | 讲解Vue3的安装、环境配置,基本语法、循环语句、生命周期、路由设置、组件、axios交互、Element-ui的使用等 |

| Spring | 讲解Spring(Bean)概念、IOC、AOP、集成jdbcTemplate/redis/事务等 |

🌹作者主页:青花锁 🌹简介:Java领域优质创作者🏆、Java微服务架构公号作者😄

🌹简历模板、学习资料、面试题库、技术互助

🌹文末获取联系方式 📝

文章目录

- 往期热门专栏回顾

- 1、前言介绍

- 1.1、文生图效果

- 2、LoRA的工作原理

- 3、LoRA的应用场景

- 4、LoRA的优势

- 5、LoRA的挑战

- 6、LoRA的实现

- 7、未来展望

1、前言介绍

在深度学习和自然语言处理领域,大规模预训练模型(如GPT-3、BERT等)已经展示了强大的能力。然而,训练这些模型需要大量的计算资源和数据,这对于许多组织和个人来说并不现实。LoRA(Low-Rank Adaptation)作为一种轻量级的微调方法,提供了一种高效且经济的解决方案。本文将详细介绍LoRA的工作原理、应用场景、以及其在大模型微调中的优势和挑战。

1.1、文生图效果

提示词:

//quality, (masterpiece:1.3), (detailed), ((,best quality,)),//,cute,1girl,//,brown cat ears,animal ear fluff,(light_brown hair:1.3),(red hair: 1.1),(red inner hair: 1.4), (straight bangs: 1.4),(,long_hair,single braid :1.4),(Ahoge),(detailed eyes,blue_eyes:1.4),medium chest,//, (yellow hairpin,crescent-shaped hairpin:1.4),off_shoulders,large red ribbon,(idol costume:1.4),thigh strap,frilled skirt,gloves,//,blush,smiling,upper_teeth,looking_down,//,hand_up,(holding microphone:1.3),(standing on stage),//,indoors,crowd of audience,Glow stick,scenery,colorful light particles,(colorful lights:1.3),(laser light:1.4),glow_in_the_dark,cowboy_shot,dynamic angle

反向提示词:

NSFW,text,(worst quality:1.331), (low quality:1.331), (normal quality:1.331), large head, extra digits, bad eye, extra fingers, fewer fingers, strange fingers, ((bad hands)), Strange eyes, Many hands, (Many arms), EasyNegativeV2, ng_deepnegative_v1_75t, pregnancy, badhandv4, six fingers, fused fingers, unclear eyes,poorly drawn,cloned face,bad face,

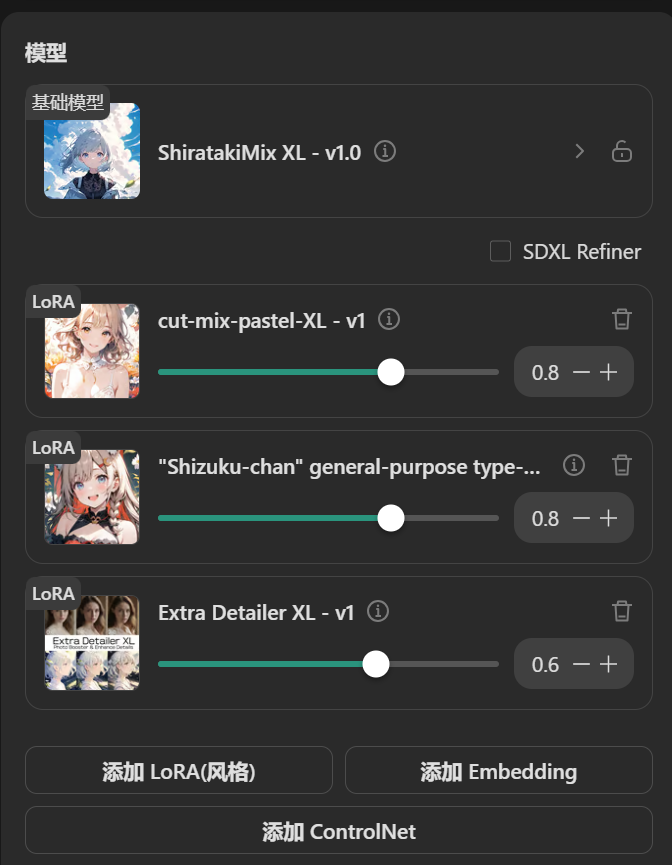

在提示词、反向提示词不变的情况下,我们在导入多个LoRA,并且调整参数,来生成我们想要的图片。

三个LoRA:

调整LoRA值之后的效果:

2、LoRA的工作原理

LoRA通过引入低秩矩阵分解技术来微调大型预训练模型。其核心思想是将预训练模型的权重矩阵分解为两个低秩矩阵的乘积,从而减少需要微调的参数数量。具体而言,LoRA假设原始权重矩阵W可以近似表示为两个低秩矩阵A和B的乘积,即W ≈ AB,其中A和B的秩远小于W的秩。

在微调过程中,LoRA仅优化低秩矩阵A和B,而保持原始模型权重W不变。这种方法不仅降低了计算复杂度,还减少了存储和传输的开销,使得微调过程更加高效。

3、LoRA的应用场景

-

自然语言处理(NLP): LoRA在NLP任务中表现出色,如文本分类、机器翻译、情感分析等。通过微调预训练模型,LoRA可以快速适应不同的语言任务和数据集。

-

计算机视觉: 在图像分类、目标检测和图像生成等任务中,LoRA也展示了强大的适应能力。通过微调预训练的视觉模型,LoRA可以在有限的计算资源下实现高效的图像处理。

-

语音识别: LoRA在语音识别和语音生成任务中同样具有广泛的应用前景。通过微调预训练的语音模型,LoRA可以有效提升语音识别的准确性和生成质量。

4、LoRA的优势

-

高效性: LoRA通过低秩矩阵分解显著减少了需要微调的参数数量,从而降低了计算复杂度和存储开销。这使得微调过程更加高效,尤其适合资源受限的环境。

-

灵活性: LoRA可以应用于各种预训练模型和任务,具有广泛的适应性。无论是NLP、计算机视觉还是语音识别,LoRA都能提供有效的微调方案。

-

经济性: 相对于全量微调(fine-tuning)大模型,LoRA需要的计算资源和时间成本大大降低。这对于小型团队和个人研究者来说尤为重要,使他们能够在有限的资源下实现高效的模型优化。

5、LoRA的挑战

-

低秩近似的局限性: LoRA依赖于低秩矩阵分解来近似表示权重矩阵。然而,在某些情况下,低秩近似可能无法充分捕捉复杂的模型结构和数据特征,导致性能下降。

-

模型选择的复杂性: 在实际应用中,不同任务和数据集对模型的需求各不相同。选择合适的预训练模型和微调策略仍然是一个挑战,需要进行大量的实验和调优。

-

安全性和隐私: 在微调过程中,模型可能会接触到敏感数据。如何在保证数据安全和隐私的前提下进行高效的微调,是LoRA面临的另一个重要挑战。

6、LoRA的实现

为了更好地理解LoRA的实际应用,以下是一个基于PyTorch的LoRA实现示例。

import torch

import torch.nn as nnclass LoRA(nn.Module):def __init__(self, model, rank=4):super(LoRA, self).__init__()self.model = modelself.rank = rankself.low_rank_modules = nn.ModuleList()for name, module in model.named_modules():if isinstance(module, nn.Linear):in_features, out_features = module.in_features, module.out_featuresA = nn.Parameter(torch.randn(out_features, rank))B = nn.Parameter(torch.randn(rank, in_features))self.low_rank_modules.append((name, A, B))def forward(self, x):for name, A, B in self.low_rank_modules:module = dict(self.model.named_modules())[name]W = module.weightlow_rank_weight = A @ Bmodule.weight = nn.Parameter(W + low_rank_weight)return self.model(x)7、未来展望

随着深度学习和大规模预训练模型的发展,LoRA作为一种高效的微调方法,将在更多领域和应用中发挥重要作用。未来,LoRA可能会进一步优化低秩分解技术,提高近似的精度和效率。此外,LoRA还可以与其他优化技术结合,形成更强大的微调框架。

总之,LoRA为大规模预训练模型的高效微调提供了新的思路和方法。通过降低计算复杂度和存储开销,LoRA使得更多人能够利用预训练模型的强大能力,推动人工智能技术的普及和应用。期待未来LoRA在更多领域中的创新和突破,为深度学习的发展注入新的活力。

资料获取,更多粉丝福利,关注下方公众号获取